그림을 넣느라 별도 답변으로 붙입니다.

제가 알기로는 Raid 1 을 했을때 하나만 멀쩡했을때, 다른 컨트롤러에 꽂았을때 하드 내부 자료를 살릴수 있는지는 케바케 라고 알고 있습니다.

컨트롤러가 어떤식으로 일하는지에 달렸습니다.

raid 1 이라고 해도, 자료를 정말 무식하게 1:1로 복사하는 컨트롤러가 있는가 하면, 아예 하드 포맷 양식부터가 NTFS나 FTA32 같은 일방적인 양식이 아니라서 동모델의 레이드 카드에 물리지 않으면 절대 못살리는 경우도 있었던걸로 기억합니다.

저는 캐쉬는 커녕 레이드 칩 조차 안 달린 컴퓨터에서 인텔 H97 메인보드에 내장된 칩셋으로 레이드 5를 돌립니다.

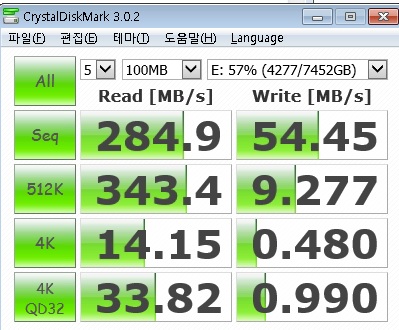

아래는 그 디스크에서 돌린 벤치입니다. 5개 연결해서 raid 5 로 물린 디스크 입니다.

쓰는데는 별 문제 없습니다. 여러명이 쓰신다면 I/O 쪽에서 문제가 생길지 모르겠는데, 일반적인 단일 하드와 비교 했을때 랜덤 읽기는 훨씬(항목에 따라 10배이상 까지) 빠르고 쓰기는 일반적인 하드에 비해 1/2 ~ 1/8 수준입니다.

Raid 5에서 연산 요구량이 가장 많은 파트가 쓰기 부분인데, 자기 본래 일하기 바쁜 메인보드 칩셋이 헉헉대며 일해도 본래 하드 절반 정도 속도는 나옵니다.(메인보드 칩셋 쓰면 raid 5 일 할때 cpu는 일 안합니다.) 메인보드 칩셋으로도 이정도는 나오는데 레이드 전용 칩셋이 있으면 더 말할 나위도 없죠.

저는 메인보드를 비롯한 시스템이 이미 결정되어 있다고는 생각을 못하고, 새로 시스템을 꾸미는 상황이라고 생각하고 메인보드 내장 Raid 5를 추천드렸던 겁니다. 만약 이미 시스템이 있으시고 거기에 확장을 목적으로 하신다면... 말씀하신 방안도 나쁘지만은 않을거라고 생각합니다.

다만 저라면 해당 구성으로 사용하시는건 그닥 추천을 하지 않겠습니다.

제가 최근 5년동안 저렇게 레이드5 상태로 쓰다가 [하드가 박살] or [레이드가 박살] 난 경우가 4차례 있었는데, 데이터는 한번도 잃지 않았습니다.

하드가 박살나도 또다른 하드가 죽기 전에만 갈아 주면 데이터 손실을 막을수 있는지라.

가장 시껍했던 경우 2위는 레이드 카드가 죽으면서 레이드 볼륨이 박살났던 경우고(동모델의 레이드 카드를 중고로 간신히 구해서 볼륨 복구) 최고로 시껍했던 경우는 스토리지가 벼락을 맞아 5장의 하드 중에 2개가 동시에 죽어버린 경우였는데요, 어떻게든 살려내긴 했습니다.

해당 내용은 http://www.typemoon.net/freeboard/1218779 참조.

저 개인적으로는, 가장 비슷한 상황을 적용가능한게 오늘 제가 매형에게 주문해 드린 스토리지 인 것 같습니다.

저희 매형이 스토리지 서버 필요하시다고 해서 또 하나 주문해 드렸는데, 해당 물건의 경우 약 200만원 정도 들었고 4테라 하드 6개를 씁니다.(그걸 레이드 5로 물려서 20테라 사용중)

Raid 5 이고 인텔 옵테인 메모리 들어가서 IO의 경우 지금 위에 붙여 놓은 벤치보다 훨씬 높게 나옵니다.

사용한 케이스는 http://prod.danawa.com/info/?pcode=3494331&cate=112775 입니다.

원래는 같은 회사에서 나온 Hera 라는 물건이 있었는데, 그 물건을 단종시키고 해당 케이스의 섀시를 그대로 가져다가 만든 물건이 저거.

(개인적으론 Hera 라는 케이스(http://prod.danawa.com/info/?pcode=2920698&cate=112775)가 더 좋았는데...)

미들타워 케이스 정도만 되어도 하드 6개를 쑤셔박고도 자리가 꽤 여유가 있읍니다. 케이스 하나에 보드랑 케이스를 다 때려박으면 정비소요가 많이 줄어드는지라...

하드 6개 박으면 그것만 해도 부피가 꽤 나가는데, 반드시 itx케이스를 써야만 하는게 아니면 이런 형태도 한번 고려해 보시는건 어떨런지요?

10년 넘게 빅타워중의 빅타워계열들의 큰 케이스만 사용해서 노이로제가 걸린것 같습니다.

이유불문 최대한 작은케이스로만 구성하고 하드가 도저히 안들어가면 무조건 외장으로 확장하려고합니다.

Mini-SAS로 제품 구입을 다 해놓고 준비중이었는데

라이젠에 커피레이크 소식때문에 우왕좌왕하다 이제는 Mini-SAS가 아닌 썬더볼트로 넘어가야하나 고민중입니다.

RAID 자체는 사용하지 않기로 하였습니다.

운용하는 서비스들이 단일볼륨을 요구하는 서비스도 아니기에 HDD에 1:1 방식으로 백업을 하려고합니다.