|

|

[필독] 처음 오시는 분을 위한 안내 (734) |

정은준1 |

2014-05 |

5126917 |

0 |

|

2014-05

5126917

1 정은준1

|

|

|

(광고) 단통법 시대의 인터넷가입 가이드(ver2.0) (234) |

백메가 백메가 |

2015-12 |

1661870 |

25 |

2015-12

1661870

1  백메가 백메가

|

|

61230 |

IOT- MQTT에 대해 잘 아시는 분 계신가요? (12) |

이희주 |

2020-07 |

4975 |

0 |

|

2020-07

4975

1 이희주

|

|

61229 |

iODD 사용에 대한 질문입니다. (3) |

정광진 |

2012-04 |

4975 |

0 |

|

2012-04

4975

1 정광진

|

|

61228 |

SCSI 문의드립니다. (3) |

이광조 |

2008-09 |

4975 |

29 |

|

2008-09

4975

1 이광조

|

|

61227 |

용산에 AAAA 베터리 파는 곳이 있을까요? (18) |

SamP |

2019-05 |

4975 |

1 |

|

2019-05

4975

1 SamP

|

|

61226 |

엔터프라이즈 8테라가 이렇게 쌀수있나요? (6) |

장동건2014 |

2015-01 |

4975 |

0 |

|

2015-01

4975

1 장동건2014

|

|

61225 |

미러링된 하드가 개별적으로도 인식이 되나요? (4) |

한조 |

2016-06 |

4975 |

0 |

|

2016-06

4975

1 한조

|

|

61224 |

비디오카드 설정 프리셋 설정하는 방법 있을까요? (1) |

악땅 |

2016-05 |

4975 |

1 |

|

2016-05

4975

1 악땅

|

|

61223 |

아래에 오실로스코프이야기가 나와서 질문드립니다. (8) |

김동민 |

2014-05 |

4975 |

0 |

|

2014-05

4975

1 김동민

|

|

61222 |

옥타코어 워크스테이션 입니다. 의견 부탁드립니다. (9) |

조세민 |

2008-08 |

4975 |

10 |

|

2008-08

4975

1 조세민

|

|

61221 |

i5 3570이나 i5 2500에 펜티엄에 쓰는 얇은 기본쿨러 써도 되나요?? (12) |

헥사코어 |

2020-07 |

4975 |

0 |

|

2020-07

4975

1 헥사코어

|

|

61220 |

컴터 화면이 안나옵니다.. (5) |

박현근 |

2007-02 |

4975 |

32 |

|

2007-02

4975

1 박현근

|

|

61219 |

Xeon LV (1) |

소현준 |

2006-08 |

4975 |

20 |

|

2006-08

4975

1 소현준

|

|

61218 |

Windows Server NFS 10G 속도... vs iSCSI (3) |

컴박 |

2018-12 |

4975 |

0 |

|

2018-12

4975

1 컴박

|

|

61217 |

win7 pro ios (15) |

AKMU AKMU |

2016-07 |

4975 |

0 |

2016-07

4975

1  AKMU AKMU

|

|

61216 |

하만카돈 오라 연결 질문 (2) |

SkyBase SkyBase |

2017-03 |

4975 |

0 |

2017-03

4975

1  SkyBase SkyBase

|

|

61215 |

SSD를 도킹스테이션으로 eSATA로 연결하려는데 실패 (7) |

yummy |

2018-12 |

4976 |

0 |

|

2018-12

4976

1 yummy

|

|

61214 |

전자부품세척은 어떻게하나요?? (9) |

행복하세 |

2016-06 |

4976 |

1 |

|

2016-06

4976

1 행복하세

|

|

61213 |

박스 큰 것 택배비 어느 회사가 저렴한가요? (8) |

김호성 |

2015-10 |

4976 |

0 |

|

2015-10

4976

1 김호성

|

|

61212 |

sata-2 외장 raid 추천부탁드립니다. (1) |

조용주 |

2006-08 |

4976 |

14 |

|

2006-08

4976

1 조용주

|

|

61211 |

디카구입관련 질문해봅니다. (2) |

구명서 |

2007-12 |

4976 |

14 |

|

2007-12

4976

1 구명서

|

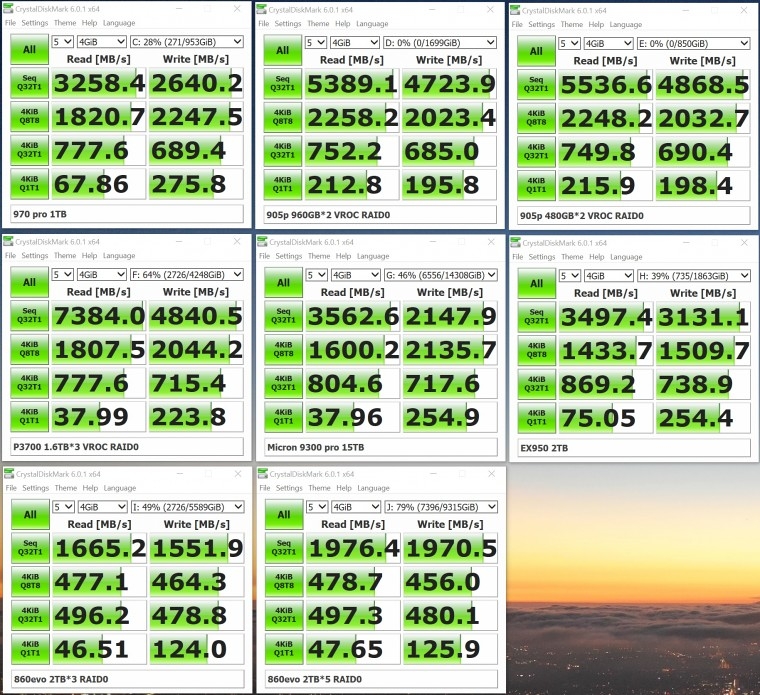

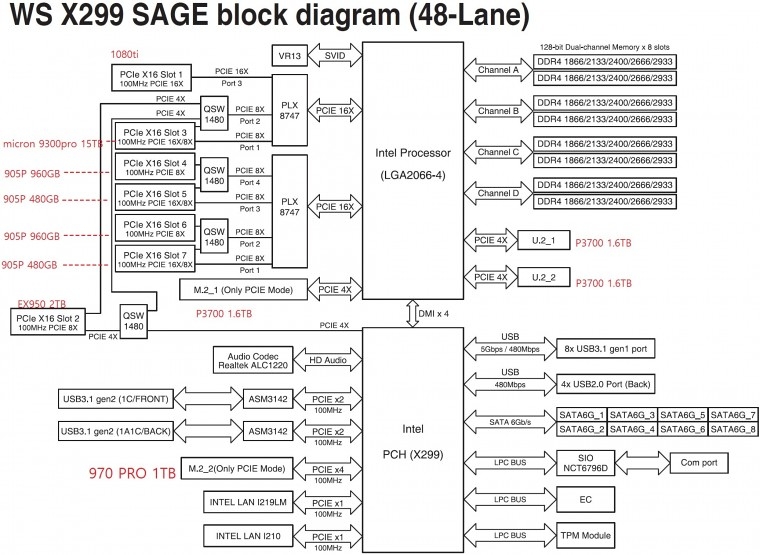

2500MB/s 이상 나오는 드라이브들을 써도 이득이 없다고 봐도 되는 걸까요 ?

pch에 여러가지가 연결되는데 그게 dmi대역폭을 다 공유하는구조이기에 bottleneck일수도있고

시퀀셜로 쓰기속도를 스펙대로 다 뽑아주는 nvme가 있을까 싶습니다..

램이 넉넉하다면 램디스크 만들어서 m.2 1번포트로 전송해보면 바틀넥인지 nvme의 한계인지 알수있을거라고 봐요.

테스트 파일크기를 더 늘리거나 더티테스트툴로 각 구간별 속도를 체크해보세요.

그리고 PCH에 연결된SSD는 PCH 대역을 공유하니 CPU에 직접연결된 SSD간 복사를 해보세요.

이때 작업관리자에서 활성시간이 높게 측정되고 있는지도 체크해보세요,

테스트 파일도 200기가 짜리등도 모두 시도해 봤지만 속도제약은 생겼습니다.

그리고 CPU간 직접연결된 드라이브끼리 복사를 한 것이었습니다.

그런데도 905p끼리 할때도, 905p와 p3700간에 할때도 제약이 걸립니다.

혹시라도 다른 의견 없으실까요 ?

감사합니다.

그럼 정말 궁금 했던것은 프리미어나 에펙같은 사용환경만을 기준으로 했을때에

고대역폭(2500MB/s가 넘어가는) 스토리지에 자금을 투자하는 것은 거의 의미없는

수준으로 되는 것인가요 ?

앞으로의 기술 발전으로 여타 다른 장치및 소프트웨어 레벨의 병목 부분들이 해결되면

당연히 다른 상황이 발생 하겠지만

현재의 기준으로는 어떻게 봐야 할지 무척 궁금 합니다.

감사 합니다.

레이드 볼륨을 기준으로 한다면, 이건 해봐야 압니다. 멤버 디스크를 지금보다 더 늘린다면 다른 결과가 나올 수 있기 때문입니다. 순차 QD1이 성능이 잘 안 나온다는 것은 어디까지나 큐 깊이가 깊을 때에 비해 잘 안 나온단 것이지 도달 가능한 성능 상한선이 존재한다는 건 아닙니다. (4K QD1은 레이드로는 뭘 해도 늘어나지 않지만 순차 QD1은 레이드 0 구성시 효율이 낮아서 그렇지 증가하긴 합니다.)

QD1 성능에 특화된 905p를 잔뜩 묶어다 볼륨을 만들면 어떤 결과물이 나올지 저도 궁금해지네요. 사실 이게 원체 비싼 물건이다 보니 두 개 장착한 경우도 만나보기 쉽지 않거든요. 저도 900p 480gb 달랑 하나만 들고 있을 뿐이고요. 만약 905p 네 개에 들어있는 자료가 없다면, 네 개를 레이드 0 볼륨으로 만든 뒤 테스트를 해보는 건 어떨까요? 용량이 달라도 일단 레이드 0 볼륨 구성은 가능하고, 905p는 기술적 특성상 용량이 다른 것끼리 묶어도 성능 손실이 있는 건 아니니까요.

VROC의 특성인지는 몰라도 벤치값은 2개때와 같았습니다.

혹시나 해서 3개로도 해봤는데 거의 오차범위로 나왔습니다.

프리미어나 에펙 같은 것에서는 비싼 드라이브가 요즘 기준으로는 필요 없다 봐야 하는군요 ㅜㅜ

그렇다면 순차QD32의 성능은 실제 사용에는 어떤 상황에 해당 되는 것일까요 ?

QD32 같은 깊은 큐 작업은 서버에서 볼 수 있습니다. 서버용 ssd 중에는 QD1 성능은 과감히 포기하고 깊은 큐 성능에 초점을 둔 물건이 있습니다. 극단적인 예시로는 삼성 1725a가 있습니다. QD32에선 6GB/s를 넘기지만, QD1에서는 700MB/s 미만입니다.

클라이언트에서는 i/o 작업의 50%~70%가 QD1이며, QD4 이하가 90% 이상을 차지합니다. 이 때문에 클라이언트 단에서 쓰이는 ssd 중에서는 QD1에 초점을 둔 물건이 근래 나오기 시작했습니다. 인텔 905p가 대표적입니다.

컴퓨터 관련 지식은 그저 겉핥기 수준 밖에 안되서

뭐하나에 부딪히면 매번 이렇게 어렵게 헤쳐나가야 되네요

정말 깊게 알고 계신 분들 너무 부럽습니다.

다시 한번 감사 드립니다.

본인께서 원하는 속도는 굳이 보실려면

nvme 갯수를 더 늘리시거나

보드를 일반데스크탑으로 바꿔 보세요

ㅡㅡ 캐쉬 설정 차이가 있는거 같습니다

속도는 레인지원수를 말씀 하시는 것인가요 ?

NVME 갯수를 늘리라는 말씀은 RAID0으로 더 늘려보라는 말씀 이신가요 ?

일반 보드라는게 어떤 보드는 어떤 보드를 말씀 하시는지 궁금합니다.

그리고 캐쉬 설정 차이라 하시면 디스크마크의 그것을 말씀 하시는건지요

VROC 설정에서 캐쉬 설정 부분은 따로 없어서 말이죠.