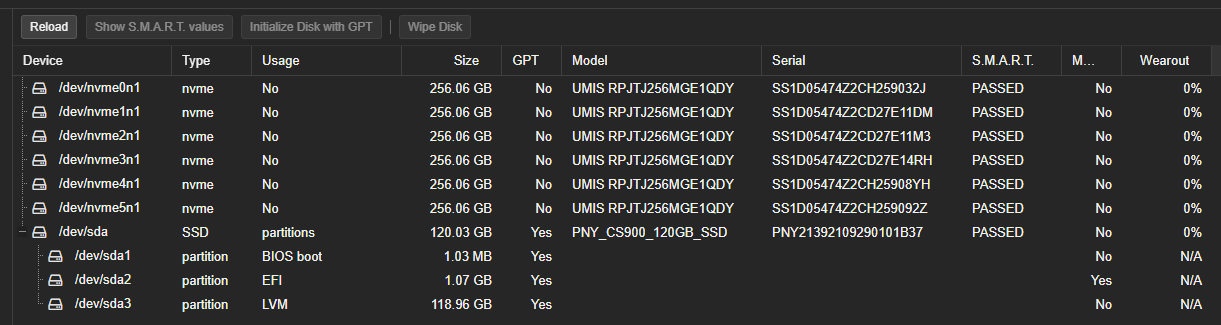

사양

CPU : Intel I3-12100

M/B : Biostar B760MXC PRO 2.0

RAM : Samsung DDR4-3200 x 8GB 2EA (T:16GB)

SSD : PNY CS900 120GB

NVMe : Union Memory AM630 M.2 NVMe 256Gb x 6EA

WiFi : RTL8822CE 2.4/5.0GHz

LAN : Intel I219-V 1G (M/B) / RTL8152 2.5G (USB3.0)

RTL8152 문제로 사용할 수 없다면, 대체 품 RTL8156 2.5G (USB 3.0) 보유 중

지금까지 해본것들 . . .

헤놀로지는 Intel LAN이라 구글링으로 얻은 정보로 S-ATA Card 없이 Port 기본 8개(CPU 4/B760 4)인 M/B를 구매했는데, IP 받고 접속 불가능한 문제에서 PCIe LAN을 추가해 성공

PCIe-M.2를 이용해 하나의 NVMe 더 설치하려고 Native에서 문제 있었던 M/B의 내장 LAN을 사용해 Proxmox VE에서 NAS (100) VM 생성 후 DS3622xs+, SA6400에서 M.2와 PCIe-M.2를 이용해 설치된 6개의 NVMe 이식이 안되 “qm set 100 –sata0~5 /dev/disk/by-id/[NVMe]”로 성공(DS3622xs+는 SCSI0~5로 가능했었음)

Diskpart에서 SSD clean 후 지금까지 진행된 상황 ^^;

Proxmox VE 8.1.4를 설치했습니다.

M.2와 PCIe-M.2를 이용해 설치한 NVMe를 헤놀에서 어떻게 스토리지 풀 만드는지 몰라 VT 기능 활성화를 위해 iommu를 설정

shell에서 “/etc/default/grub”

설정 값 “intel_iommu=on” 입력 저장 후 종료

shell에서 “update-grub”

reboot ( 업데이트했지만 오래 걸리지 않기에 진행 )

VM으로 만들어질 헤놀로지와 Windows10을 위해 이미지파일 업로드

local (pve) - ISO Images – Upload – RR24.3.9.img

local (pve) - ISO Images – Upload – Windows10.ISO

헤놀로지로 사용될 NAS (100)는 다음과 같은 방법으로 만들어질 예정?입니다.

업로드한 이미지를 CD로 인식하지 않고 pve shell에서 “qm importdisk 100 /var/lib/vz/template/iso/RR24.3.9.img local-lvm”입력 임포트한 이미즈를 NAS (100)의 hardware 탭에서 SCSI0 + Write-back으로 설정변경, booting 탭에서 SCSI 0을 최우선 부팅순서로 올려줌.

참고한 영상

설치될 헤놀로지가 DS3622xs+일 땐, 임포트된 이미지를 IDE, SCSI 중 번호 관계없이 설정하고 SA6400일 땐, 아직 M.2와 PCIe에 설치된 NVMe 전체로 스토리지풀 만드는 방법을 찾지 못해 부팅은 IDE로 설정하고 저장장치 인식을 못해 설치 진행할 수 없는 문제를 해결하기 위해 2GB SATA HDD를 만들어 진행했었습니다. ( 여기까지 검색과 구글링 + YouTube 후 부팅이 안 되는 문제가 몇 번 있어서 한쪽 눈 감고?까지는 할 수 있습니다. )

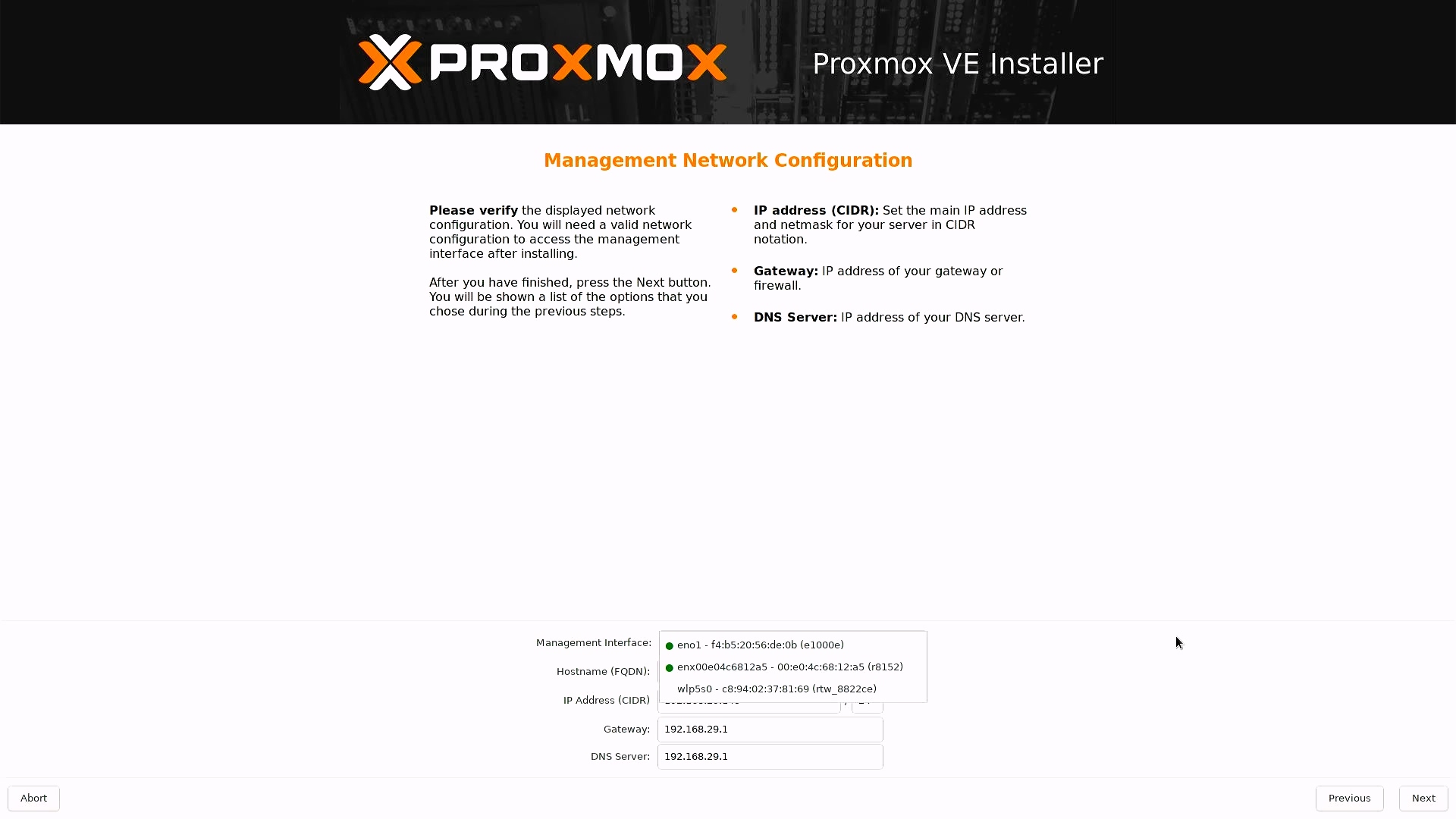

eno1 – f4:b5:20:56:de:0b (e1000e)

M/B Intel I219-V 1G LAN

enx00e04c6812a5 – 00:e0:4c:68:12:a5 (r8152)

USB 3.0 RTL8152 2.5G LAN

wlp5s0 – c8:94:02:37:81:69 (rtw_8822ce)

M/B M.2 RTL8822CE 2.5/5.0GHz WiFi

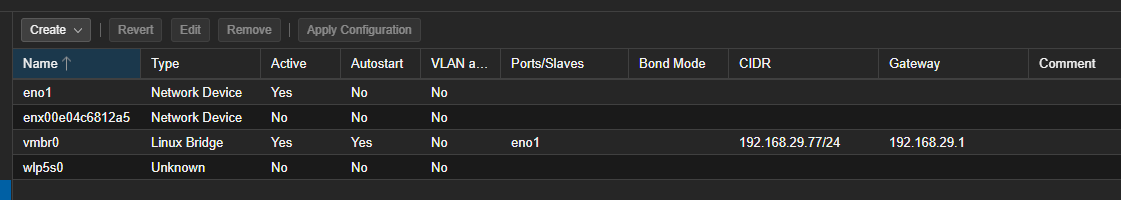

Proxmox VE 관리자?는 1G LAN 네트워크인 [ eno1 ]를 사용하고 VM_100으로 설치된 헤놀로지는 속도를 위해 단독으로 [ enx00e04c6812a5 ]를 사용하도록 하고 싶습니다.

Q1. 만들어질 NAS (100)에서 후면 USB 3.0에 연결한 2.5G LAN을 헤놀로지만 단독으로 사용하기 위해 VM 만들기 전? 후? 어떻게 어떤 설정을 해줘야 가능한가요?

YouTube에서 USB 3.0으로 연결한 2.5 LAN을 다이렉트?로 연결하는 영상이 있어 해봤었습니다만, 재부팅 후 접속 불가능이었습니다.

참고한 영상

shell nano / etc/network/interfaces

auto vmbr1

iface vmbr1 inet manual

bridge-ports enx00e04c6812a5

bridge-stp off

bridge-fd 0

Q2. Proxmox VE 설치할 때 연결되어 있지는 않았었고 얼마 되지 않은 네트워크 분산 사용 또는 경험을 위해 VM_200으로 설치될 Windows10에서 [ wlp5s0 ] 단독으로 사용하려면 어떻게 해야 하나요? ( SSID : ABCD / PASS : 1234 )

현지에 계시는 분 또는 고수님이 많이 계시지만, 저는 “바탕화면에 폴더 만들어 사용하세요.”라는 답았을 때 바탕화면 아이콘이 없는 곳에 마우스 두고 우측 버튼 새폴더 만들기로 가능한 걸 이해 못 할 정도의 약골입니다.

잘~ 부탁드립니다. (º,º) (_ _)

전기적으로나 논리적으로 passthrough가 당장은 불가하실 수 있습니다. 거의 기본값으로 각 장치가 할당되는 번지수(iommu)가 한 번지에 여러 장치들이 물려있는게 기본값일거거든요.

그래서 논리적으로라도 분리하여 장치를 사용하려먼 iommu=pt를 넣은 위치에 몇 단어 추가하여 grub을 편집하시면 되는데, pcie_acs_override=downstream,multifunction을 추가하신 뒤, initramfs 하고, 재부팅하시고, 해당 vm의 hardware탭에서 add>pci device를 누르신 뒤, 각 장치마다 iommu가 모두 다르다면 해당 장치만 vm에 오롯이 붙여줄 수 있습니다.

쉽게 말하자면 컨트롤러 단위로 disk나 usb장치를 Passthrough할 수 있기 때문에 언급하신 interface파일 자체를 건드릴 이유도 사라집니다.

기억에 의존한 거라서.. 정확하지 않을 수 있으니, 부디 교차검증하시고 적용하시면 될 것 같습니다.

“설치될 헤놀로지가 DS3622xs+일 땐, ” 문단은 제가 이해를 하지 못하였습니다만, 이해하는대로 답변을 달아보자면.. nvme는 각각 iommu가 할당되기 때문에 전체를 vm에 넣으면 그대로 사용하실 수 있습니다. (경험상 Sata같은 경우는 컨트롤러 단위, nvme는 개별로 iommu할당됨) OS 이미지는 굳이 local 밖을 나갈 필요가 없다는 의견입니다. 나가는 순간 스냅샷 등 좋은 기능을 버리게 되니까요.

지금 하신대로 bridge 인터페이스를 만들어서 헤놀로지에 연결하시면 가상화 레이어를 통과해서 proxmox가 지원하는 몇가지 NIC으로 에뮬레이트해서 사용이 가능합니다. 그게 오히려 편하고 쉬운 방법입니다.

다른 방법으로는 usb 디바이스를 패스스루 해서 헤놀로지에 할당합니다. VM을 만든 이후에 VM->hardware->add 하셔서 USB 랜을 직접적으로 연결해 주시면 됩니다.

Q2)

무선랜은 패스스루 해보지는 않았지만 무선랜 디바이스를 Windows10 VM에 패스스루 해주시면 되실겁니다.

가능한 방법은 크게 2가지가 있습니다

1. 장치자체를 패스해서 할당

2. 가상 스위치에 USB NIC랑 시놀만 할당해서 혼자 독점하게 설정 (혼자밖에 없으니 독점적으로 대역폭 다 쓰게 됩니다)

1경우는 게스트의 OS가 지원해야 하기땜에 드라이버 설치등을 마쳐서 작동 확인후 하셔야 하고, 차후 업데이트등으로 접속이 안 될떄 좀 귀찮을 수 있습니다

따라서 추천은 2번입니다

게스트 OS 상관없이 대충 저런식이라 보시면 됩니다

다행히 Proxmox는 리눅 기반이라 대부분의 NIC Driver를 지원 가능하므로 어떤 장치라도 설정은 가능할껍니다

거기다 무선랜같은 PCIe를 1번으로 연결할 경우 보드의 구조적 토플로지도 엃히게 됩니다

보드 구조에 따라서 하나의 장치만 따로 패스할 수 없을 수 도 있습니다