|

453 |

Cat8 케이블 (8) |

Sakura24 |

04-12 |

527 |

0 |

|

04-12

527

1 Sakura24

|

|

452 |

인터넷 회선 3개가 스위칭장비에 꽂혀도 되나요? (19) |

비오는날우산 |

04-03 |

531 |

0 |

|

04-03

531

1 비오는날우산

|

|

451 |

인터넷 회선 3개가 스위칭장비에 꽂혀도 되나요? (6) |

박 |

04-03 |

406 |

0 |

|

04-03

406

1 박

|

|

450 |

인텔 리테일 랜카드 보증 관련하여 (11) |

아이브릿지 |

04-01 |

445 |

0 |

|

04-01

445

1 아이브릿지

|

|

449 |

이런 구성으로 별 문제 없이 작동할까요? (6) |

Sakura24 |

03-30 |

446 |

0 |

|

03-30

446

1 Sakura24

|

|

448 |

고클럭 홈서버 후속 질문입니다. (24) |

Pathway |

03-27 |

671 |

0 |

|

03-27

671

1 Pathway

|

|

447 |

컴퓨터 두대를 같이 켜고 싶은데 (15) |

구차니 구차니 |

03-19 |

861 |

0 |

03-19

861

1  구차니 구차니

|

|

446 |

FC어댑터 케이블 질문과.. 메모리 인식 관련 질문 입니다. (13) |

홀릭0o0 |

03-16 |

546 |

0 |

|

03-16

546

1 홀릭0o0

|

|

445 |

네트워크 구성 질문드립니다 (9) |

케치 |

03-16 |

710 |

0 |

|

03-16

710

1 케치

|

|

444 |

sas 와 fc 가 하나로 통합되어 있는 카드도 있나요? (17) |

마왕 |

03-07 |

620 |

0 |

|

03-07

620

1 마왕

|

|

443 |

UTM 문의 (10) |

이원재K |

03-04 |

734 |

0 |

|

03-04

734

1 이원재K

|

|

442 |

Fatal Error 에러 문의드립니다. (17) |

디브이 |

03-01 |

952 |

0 |

|

03-01

952

1 디브이

|

|

441 |

libgen 과 같은 개인 저장소를 갖추려면? (12) |

GoverZG |

02-26 |

818 |

0 |

|

02-26

818

1 GoverZG

|

|

440 |

SMB 멀티채널에서 속도..?ㅜㅜ (13) |

gusoong |

02-22 |

994 |

0 |

|

02-22

994

1 gusoong

|

|

439 |

iperf3 로 dual nic 속도 측정 가능한가요? (20) |

구차니 구차니 |

02-19 |

598 |

0 |

02-19

598

1  구차니 구차니

|

|

438 |

JBOD & JBOF (6) |

박문형 |

02-18 |

625 |

0 |

|

02-18

625

1 박문형

|

|

437 |

SFP-10G 모듈 호환성 관련 문의입니다. (4) |

잉여 |

02-17 |

587 |

0 |

|

02-17

587

1 잉여

|

|

436 |

리테일 랜카드 펌웨어를 밴더사로 변경이 가능한지 궁금합니다 (10) |

홀릭0o0 |

02-16 |

608 |

0 |

|

02-16

608

1 홀릭0o0

|

|

435 |

dell 오류 표기 관련 질문. (22) |

홀릭0o0 |

02-10 |

1032 |

0 |

|

02-10

1032

1 홀릭0o0

|

|

434 |

노트북에 SAS 컨트롤러 장착? (16) |

INMD |

02-02 |

1068 |

0 |

|

02-02

1068

1 INMD

|

300대 이상의 Device 를 컨트롤한다면 요구 되겠지만.

필요없을 것 같습니다.

대역폭 충분하니 XE512EM 도 충분해 보입니다.

총 나스3대 하부 스위치 3대 pc약 20대정도 10g접속 커버 하려고 합니다

그럼 XE724EM 을 쓰셔야겠네요.

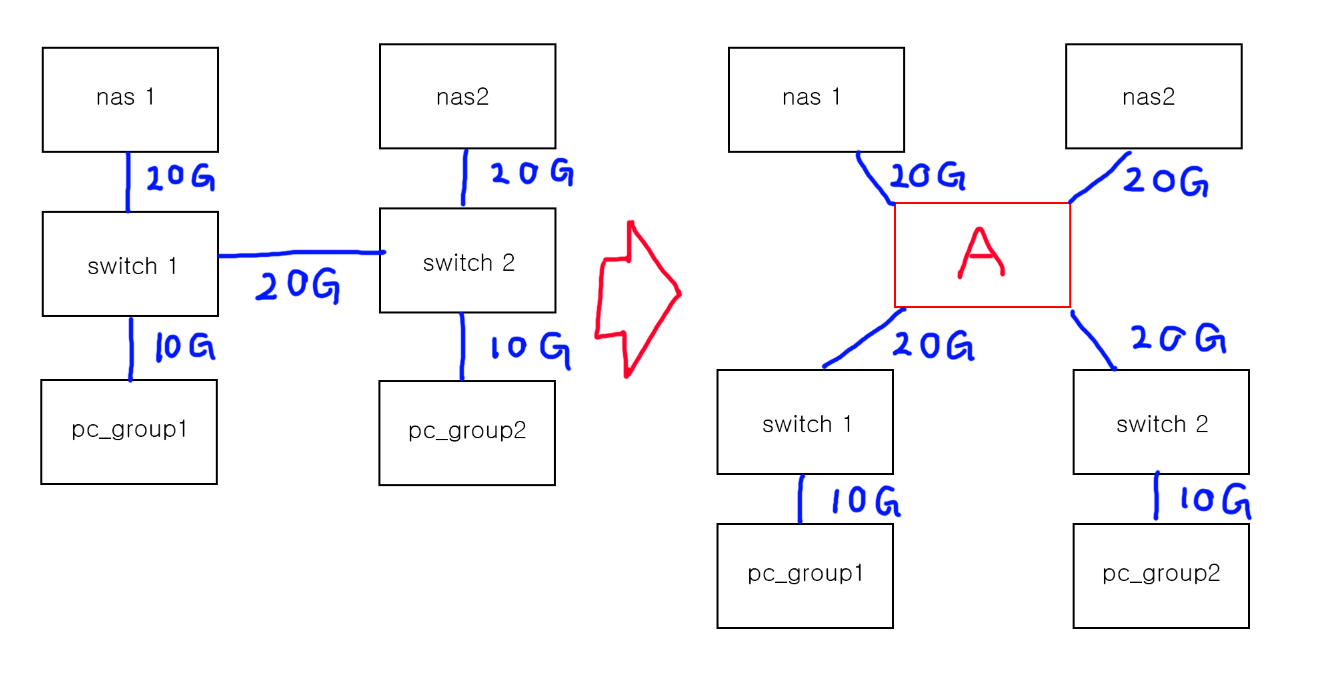

오른쪽그림의 A스위치에 연결된 최대대역폭은 20G 연결이 4개이니 총 80G가 되겠죠?

따라서 A 스위치는 훨씬더 대역폭이 높은 장비를 써야 가능한 연결이 됩니다.

연결을 어떻게 하건 대역폭이 안모자랄수 밖에 없지 않나요?

특별히 확인해야 할 다른 스펙이 있을지 궁금합니다

대충 생각해 봤을때 왼쪽 구조에서는 pc들이 각 스위치를 안지나갈수도있는데

오른쪽 구조에서는 모든 연결이 A를 통하게 되니 뭔가 더 좋은 스펙이 필요한걸까 생각이 되어서요

이런 장비는 각 층의 스위치 모듈끼리 백본 (뒤쪽 전용통신 기판??) 에 물려 있는데 대역폭이 높습니다..

https://www.hpe.com/psnow/doc/c04293383.html?jumpid=in_pdp-psnow-qs

여기서 Performance 확인해보시면 됩니다..

이것은 하나의 예이지만 위의 스위치끼리 전용 통신로를 구축하여 100G 급으로 묶었다라고 보시면 됩니다..

링크에서 Switch fabric speed 1015 Gbps 나오는데 물리적 백본 성능이 1015G 라는 뜻으로 해석하면 됩니다.. (제 해석이 틀릴수도 있습니다..)

위 장비는 보통 통신사 IDC 백본을 구성할 때나 은행 /병원 같은 고성능 고품질의 네트워크를 꾸밀때 사용되는데

오더 메이드 제품이라고 봐야 하고 어떻게 구성하느냐에 따라 가격이 달라지지만 몇천만원 급 장비라고 생각하시면 됩니다..

그리고 자세한 스팩이나 성능은 대형 장비에서는 표기되어 있는 경우가 많지만 작은 장비에서는 표기가 없는 경우가 많습니다..

제조사마다 스팩은 어느 정도 비슷하지만 성능은 다르게 표기되는 경우가 꽤 있습니다..

그래서 비교하기가 좀 힘듭니다..

그림의 스위치 1과 스위치 2를 6포트로 묶으면 (극단적이긴 하지만) 아마도 딜레이가 덜해질 겁니다..

AMD EPYC 프로세서도 1개의 프로세서는 128PCIe 레인이고 2개의 프로세서로 구성해도 128 PCIe 레인인데

두개의 프로세서간에는 16 PCIe 레인으로 묶여 있습니다..