|

|

(광고) 단통법 시대의 인터넷가입 가이드(ver2.0) (234) |

백메가 백메가 |

2015-12 |

1779954 |

25 |

2015-12

1779954

1  백메가 백메가

|

|

|

[필독] 처음 오시는 분을 위한 안내 (737) |

정은준1 |

2014-05 |

5255025 |

0 |

|

2014-05

5255025

1 정은준1

|

|

5475 |

아직 죽지 않은 s1867 (6) |

박이준 |

2004-08 |

4263 |

29 |

|

2004-08

4263

1 박이준

|

|

5474 |

APPLE용 SCSI HDD 250M(50pin) (1) |

이선규 |

2006-04 |

4264 |

74 |

|

2006-04

4264

1 이선규

|

|

5473 |

TEST중인 Intel Server Platform ISP1100(1U) |

이선규 |

2005-11 |

4264 |

40 |

|

2005-11

4264

1 이선규

|

|

5472 |

SUPERMICRO H8DCE (Opteron Dual-Core ready) (4) |

안창준 |

2005-06 |

4265 |

52 |

|

2005-06

4265

1 안창준

|

|

5471 |

PM3755U2B (1) |

최경민 |

2006-02 |

4266 |

54 |

|

2006-02

4266

1 최경민

|

|

5470 |

듀얼 입문 부터 삐걱거린.... (2) |

박학준 |

2005-11 |

4267 |

97 |

|

2005-11

4267

1 박학준

|

|

5469 |

Rioworks HDAMB/HDAMB-WO |

이장재 |

2004-05 |

4268 |

78 |

|

2004-05

4268

1 이장재

|

|

5468 |

[구형장비] 3com 오피스 커넥터 시리즈 (1) |

한명훈 |

2005-11 |

4269 |

72 |

|

2005-11

4269

1 한명훈

|

|

5467 |

18시간동안의 고통.. (4) |

장우석 |

2005-10 |

4275 |

98 |

|

2005-10

4275

1 장우석

|

|

5466 |

지포스 6600ge (3) |

김대성 |

2005-12 |

4276 |

76 |

|

2005-12

4276

1 김대성

|

|

5465 |

BTX type2 -- PICO라는 이름으로 새로 시작되는 군요. (5) |

이광호 |

2006-04 |

4277 |

40 |

|

2006-04

4277

1 이광호

|

|

5464 |

파워 해외에 주문한 내역입니다. (8) |

박현문 |

2004-03 |

4278 |

47 |

|

2004-03

4278

1 박현문

|

|

5463 |

Power Tester 휴대용. (15) |

이광호 |

2006-04 |

4279 |

62 |

|

2006-04

4279

1 이광호

|

|

5462 |

랩터 150GB HD Tach 및 Sandra 벤치 (정상은 아닌듯 합니다). (6) |

손상욱 |

2006-04 |

4279 |

76 |

|

2006-04

4279

1 손상욱

|

|

5461 |

[사용기] Comserver Cooljag Cooler \"CJC26AA\" 리뷰 |

정은준 |

2004-09 |

4281 |

98 |

|

2004-09

4281

1 정은준

|

|

5460 |

처음올리는 시스템.. (5) |

이여백 |

2004-03 |

4283 |

36 |

|

2004-03

4283

1 이여백

|

|

5459 |

Gigabyte GA-K8NS ultra 939 와 애슬론64 X2 4200+ 고난기... (4) |

고연조 |

2005-10 |

4284 |

113 |

|

2005-10

4284

1 고연조

|

|

5458 |

모건 코어 듀론 듀얼(수정) (1) |

양국형 |

2005-05 |

4285 |

41 |

|

2005-05

4285

1 양국형

|

|

5457 |

아수스 NCCH-DL고난기 |

황인국 |

2007-03 |

4287 |

75 |

|

2007-03

4287

1 황인국

|

|

5456 |

3DFX Voodoo 1 (3) |

김덕기 |

2005-11 |

4288 |

63 |

|

2005-11

4288

1 김덕기

|

침이 질질나오네요.

일반 웹에서 사용하는거랑

로컬로 돌리는거랑 가장 큰차이 뭘까요?

리마같은거 돌리시는거죠?

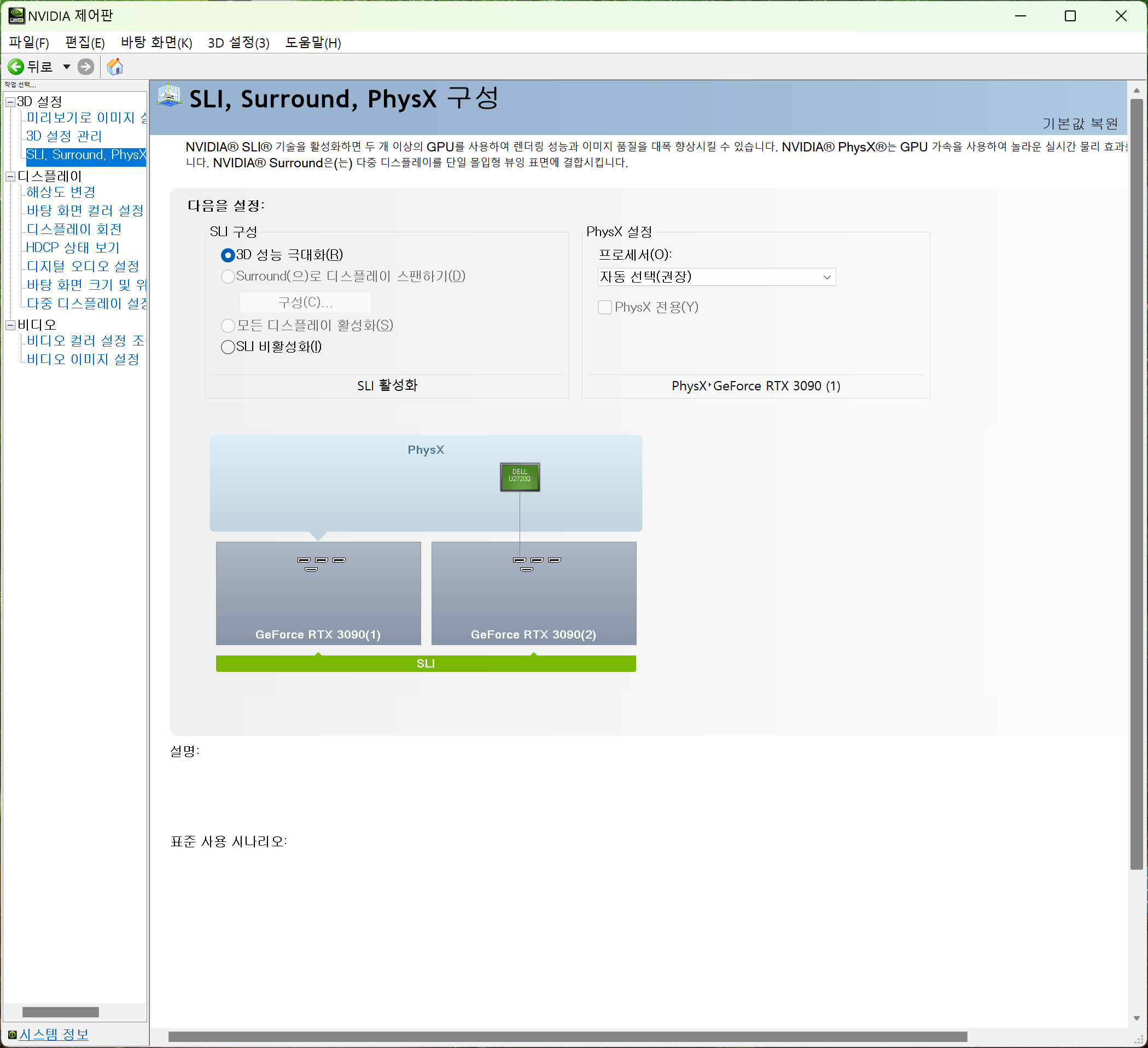

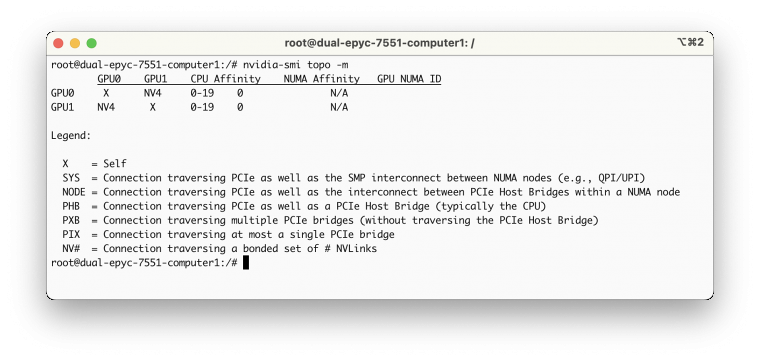

A6000 이 벤치마크에서 초당 45 토큰 처리 능력이 있고 3090 2개 NVlink는 초당 18 토큰 정도 성능이 나온다고 합니다. LLAMA 를 돌리기 위해서는 A6000이 아주 좋은 선택이지만 배우는 입장이라 3090 2개 NVlink를 선택해 보았습니다.

저는 LLAMA 보다는 3차원 피부 주름 데이타를 pytorch 를 이용한 wavelet 분석을 해야 하기에 3090 혹은 4090 GPU 여러 개를 이용한 분석이 저의 경우에는 더 적합합니다.