|

|

(광고) 단통법 시대의 인터넷가입 가이드(ver2.0) (234) |

백메가 백메가 |

2015-12 |

1746748 |

25 |

2015-12

1746748

1  백메가 백메가

|

|

|

[필독] 처음 오시는 분을 위한 안내 (737) |

정은준1 |

2014-05 |

5217209 |

0 |

|

2014-05

5217209

1 정은준1

|

|

2424 |

(VMWare) vmware 라이센스 질문 드립니다. (3) |

archetype |

2023-06 |

8092 |

0 |

|

2023-06

8092

1 archetype

|

|

2423 |

(VMWare) PowerCLI 잘 아시는분 계신가요(NSX 설정관련) (2) |

osthek83 |

2023-06 |

13410 |

0 |

|

2023-06

13410

1 osthek83

|

|

2422 |

(etc) 리눅스 로그인후 자동실행~ (3) |

회상2 |

2023-06 |

14833 |

0 |

|

2023-06

14833

1 회상2

|

|

2421 |

(VMWare) VSAN 트래픽이 포트 한쪽으로만 흐르는거 같습니다. (18) |

osthek83 |

2023-06 |

23111 |

0 |

|

2023-06

23111

1 osthek83

|

|

2420 |

(VMWare) vsish 사용법 잘 아시는분 계신가요?(feat LLDP) (3) |

osthek83 |

2023-06 |

24432 |

0 |

|

2023-06

24432

1 osthek83

|

|

2419 |

(VMWare) 다중 구동이 실질적으로 가능할까요? (4) |

포병 |

2023-06 |

25085 |

0 |

|

2023-06

25085

1 포병

|

|

2418 |

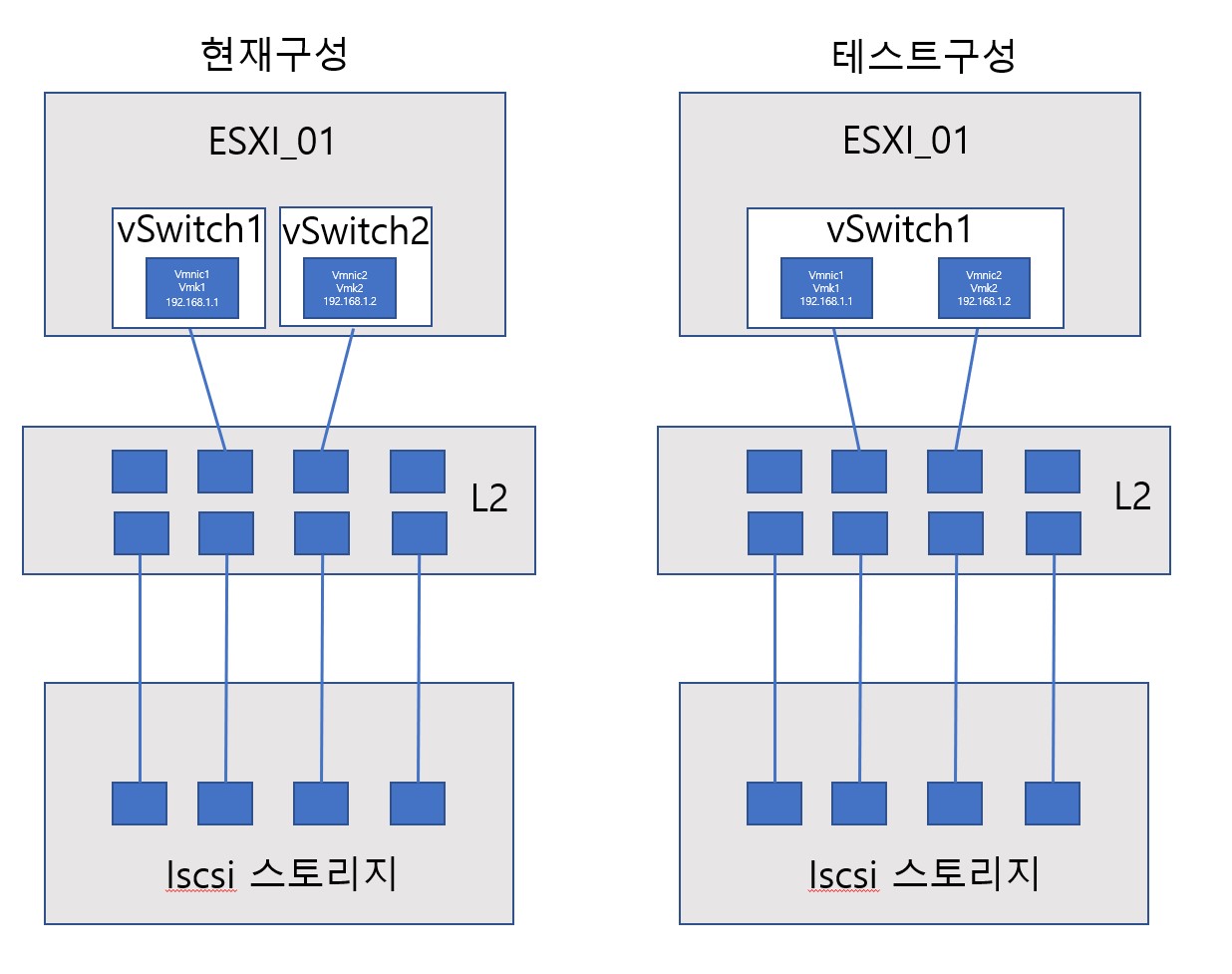

(VMWare) 호스트 3대와 iscsi 스토리지 연결중에 vSwitch 구성 관련… (3) |

전산직딩 |

2023-05 |

29162 |

0 |

|

2023-05

29162

1 전산직딩

|

|

2417 |

(VMWare) nsx-t 교육자료 구합니다. (1) |

sdlfkjwer |

2023-05 |

25300 |

0 |

|

2023-05

25300

1 sdlfkjwer

|

|

2416 |

(Hyper-V) Hyper-V로 이게 가능한건가요? (13) |

개발자는개… |

2023-05 |

22853 |

0 |

|

2023-05

22853

1 개발자는개…

|

|

2415 |

(Xen) 해상도 변경 안되는 문제 (3) |

방랑자7 |

2023-05 |

18072 |

0 |

|

2023-05

18072

1 방랑자7

|

|

2414 |

(VMWare) esxi8 정전후 네트워크어댑터 지정불가 (8) |

흐으음 |

2023-05 |

19554 |

1 |

|

2023-05

19554

1 흐으음

|

|

2413 |

(VMWare) 게스트 os간 통신방법 문의 (7) |

RHNS |

2023-05 |

20911 |

0 |

|

2023-05

20911

1 RHNS

|

|

2412 |

(Hyper-V) Hyper-V 채굴 (6) |

서버같은인생 |

2023-05 |

19485 |

0 |

|

2023-05

19485

1 서버같은인생

|

|

2411 |

(VMWare) 컴퓨터 업그레이드 고민입니다. (11) |

포병 |

2023-05 |

17661 |

0 |

|

2023-05

17661

1 포병

|

|

2410 |

(VMWare) 풀뱅 실패입니다 (10) |

김현린 |

2023-05 |

20573 |

0 |

|

2023-05

20573

1 김현린

|

|

2409 |

(VMWare) MGMT 포트 1G, 10G 질문 (3) |

winner712 |

2023-05 |

15942 |

0 |

|

2023-05

15942

1 winner712

|

|

2408 |

(VMWare) i9 데탑에 RTX2080 4개 꼽고 ESXI 무료 버전 설치로 가상… (7) |

전산직딩 |

2023-05 |

15742 |

0 |

|

2023-05

15742

1 전산직딩

|

|

2407 |

(VMWare) ESXi 6.7 버전인데, 8.0으로 업그레이드 해도 문제가 없을… (5) |

폴리76 |

2023-05 |

11279 |

0 |

|

2023-05

11279

1 폴리76

|

|

2406 |

(VMWare) GRAID NVMe-oF 연결 시도 (2) |

송주환 송주환 |

2023-05 |

10539 |

0 |

2023-05

10539

1  송주환 송주환

|

|

2405 |

(etc) proxmox 는 윈도우 중첩가상화를 지원하지 않나요? (5) |

호야리1 |

2023-05 |

15994 |

0 |

|

2023-05

15994

1 호야리1

|

https://docs.vmware.com/kr/VMware-vSphere/7.0/com.vmware.vsphere.storage.doc/GUID-4C19E34E-764C-4069-9D9F-D0F779F2A96C.html

에 문서를 참고 하시면 여러 예시로 구성 방법에 대해서 잘 나와있으니 참고 하시면 됩니다.

추가 케이블 포설로 Bandwidth을 추가가 당연히 효과가 있지만, 그에 필요한 조건은 과연 스토리지 디스크 속도가 그 만큼이 나오냐 입니다.

디스크 속도가 그 정도 안 나오면 추가 안 하시는게 Overhead 측면에서 좋습니다.

주의 사항:

- 단일 Subnet인 경우에는 Port binding 활성화, 복수 Subnet 인경우에는 Port Binding 비 권장.

- Multi-Path로 동작 하기 때문에 Failover 사용 금지(현재 테스트 구성 기준에서는 Teaming을 Active-Unused, Unused-Active 로 설정)

- ESXi에서 기본으로 Round-Robin 설정이 안 되어 있기 때문에 별도 설정 필요. (Volume Path에서 (I/O)가 정상적으로 표시 되어 있는지 확인 필수)

멀티패스로 동작한다는 말씀이 현재구성에서는 페일로버를 구성을 하면 안된다는건지요??

만약에 단순히 ESXI에서 하나의 스위치를 아래와 같이 설정하면 분산시스템???(메뉴얼에서)에 의해 2port로 VM이 분배되어 통신한다고 적혀있는데 이때는 페일백 설정으 아니오로 해야될까요?

기본적으로 페일백은 예로 설정 되어 있습니다.

기존 구성은 vSwitch에 하나의 pNIC만 있기 때문에 Failover 대상이 없지만,

테스트 구성에서는 Failover을 하면 안 되기 때문에 vPG의 Teaming 정책에서 A/U, U/A 구성을 해서 Failover을 방지 해야 합니다.