어찌보면 당연한 건데 일기 느낌으로 초보가 깨달은 점을 적어 보고자 합니다.

현재 2689v1 듀얼 64기가램 (레이드 카드 없음) 시스템 1개,

그리고 2670v1 듀얼시스템 48기가 램 (레이드 카드 있음) 2 개에 도커 컨테이너 여러 개를 돌리고 있습니다.

총 3개의 시스템인데요.

<그중에 2689시스템 빼고 2670 두 시스템만 레이드 카드에 ssd를 물린 상태입니다.

세 시스템 모두 swap파일을 ssd에 만들어 두어 활용하고 있습니다. (작업 중 램이 살짝 모자른데 컨테이너 몇 개 더 돌리자고 램 추가하긴 아까워 swap파일을 활용하고 있습니다.)>

자!

누가 봐도 2689시스템이 좀 더 원활해야 하지만 그렇지 않더군요!! 허헐..

(동일한)컨테이너 갯수로 비교하자면 2689는 57개에도 버벅이는 느낌이 발생하고 idle 상태인 프로세서 자원이 있음에도 그렇더군요..

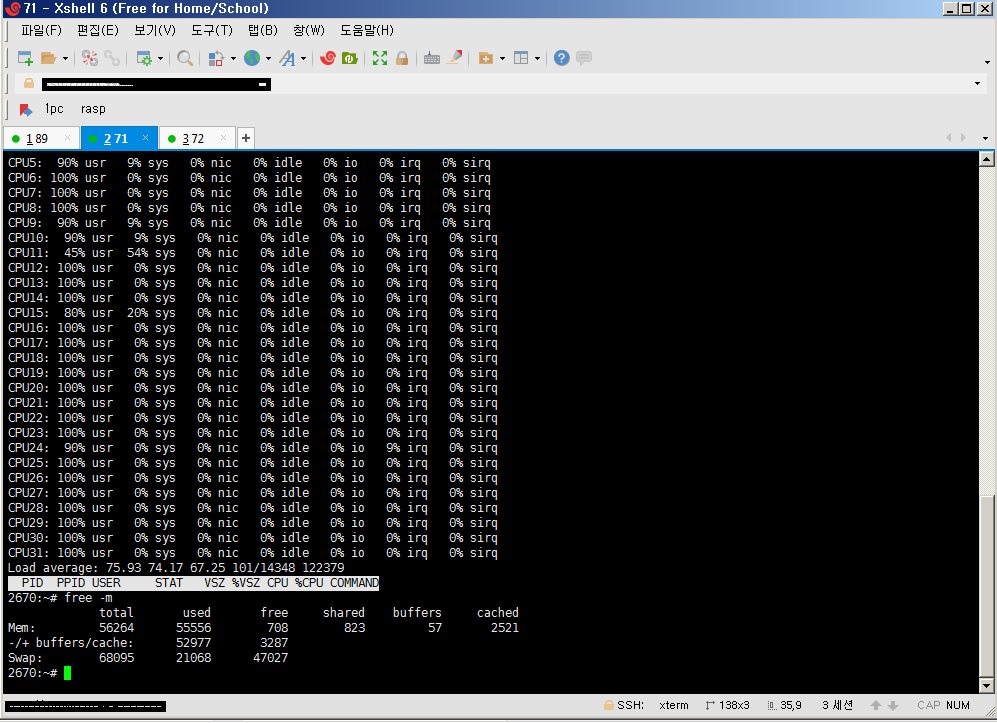

2670은 idle이 없이 프로세서 자원 100%로 끌어다 써도 2689 시스템보단 원활합니다. 무려 62개가 동시에 돌아감에도요..

더 낮은 사양의 시스템이 더 많은 컨테이너를 수용해도 무리가 없는 상태인데요.

이유가 레이드 카드 사용 유무인 것 같습니다.

잦은 swap 파일 입출력에 따른 병목현상!!! 스샷을 각각 찍었는데요. 봐보세요.(참고로 알파인 리눅스 사용하고 있습니다. 윈도우 10에서 리눅스로 넘어왔는데.. 이건 또 신세계네요.. ㄷㄷ 별 차이가 없을 줄 알았어요. 해보니 엄청 차이가 크네요. 와..)

2689 레이드 카드가 없어 swap파일 활용시 병목 현상이 발생으로 추측

2670 시스템 io 거의 0%에 램이 56기가(48에서 4기가 짜리 두 개 달아 줌)임에도 2689 64기가램 시스템보다 원활함..

체감하기론 아예 램이 더 낮아도 swap파일 세팅만으로 무리없어 보임

2670 위와 동일 램만 48기가

레이드 카드의 사용 목적이 입출력에 따른 병목 현상을 없애는 게 주요하다고 보았는데 실제 체감했네요.

저는 단순히 프로세서 자원을 입출력이 점유하는 문제에서 끝나는 건 줄 알았는데(가져가서 병목현상 없게 잘 쓰면 문제가 없으리라 생각함. 프로세서를 덜 쓰면 되는 거겠지... 라고 생각함)

헌데 입출력이 프로세서 자원을 뺏어 먹는 건 둘째치고 뺏어 먹어도 프로세서 쓰레드들 idle 상태임에도 병목이 발생하더란 점.(이게 포인트..)

결론적으로 레이드 카드가 입출력이 잦을 땐 엄청 중요한 거구나를 깨달았습니다... (레이드 활용할 것도 아니고 이게 굳이 필요한가 싶었거든요;;)

(하는 작업에 따라 다르겠지만) 레이드 카드를 통해 스왑 파일로 스왑하면서 하니 램 부족도 전혀 무리가 없었단 결과네요..ㄷㄷ

레이드 카드 모델은 아마 이거일 거에요.(모양은 같은데 모델명은 정확치 않네요;;) 다른데선 현재 3? 만원 정도 최저가로 봤고요.

2689시스템에도 위와 비슷한 느낌의 것을 하나 달아줘봐야 겠네요.

감사합니다. (__) 일기 끝.

캐쉬 메모리 없는 레이드 카드는 고 부하를 감당하지 못해서 느립니다..

가상화 시스템은 한개의 물리적 시스템에 여러개의 시스템 OS가 한꺼번에 돌아가는 것인지라 디스크및 네트워크 I/O가 높아집니다..

따라서 어느 정도는 하드웨어적으로 캐쉬 달린 레이드 장비는 필수입니다..

아하 하드웨어 캐쉬메모리의 역할이 중요했던 것이었군요..

저는 여러 가지로 생소하고 그냥 잘 되겠지? 싶어하는 막연한 바람이 앞서는 수준인데요. 그러다 보니 뒤늦게 뭔가 느껴지는 게 하나 둘 생기는 것 같습니다.

프로세싱 파워는 모자름이 없을텐데 무슨 차이일까 궁금했는데 알려주셔서 감사합니다.(사실 qna에 올리려다가 자제한 건데요. 가려운 부분을 딱.. ㄷㄷ)

그렇게 슬슬 최근엔 스토리지 서버(뭔지 몰라서 군침만 흘리는 중.. 게다가 디스크 가격도 ㄷㄷ)에 관심이 생겨 qna게시판을 보고 있는데 박문형님 글들이 진짜 큰 도움이 되고 있습니다. 이 자리를 빌어 감사드립니다.(__)

특히 동시에 입출력 발생하면... ㅎㅎㅎㅎ

다다익램으로 밀어붙이면 좋겠지만 비용이 필요 이상으로 커진다 싶어서 스왑 파일로 해보게 되었는데

저의 경우 만족 100%이고 램 값을 적잖이 아끼게 된 결과네요.

말씀대로 동시에 입출력이 발생하다보니 레이드 카드 사용 유무가 눈에 띌 정도더군요..

현재 유통되는레이드 카드들은 어느정도 상향 평준화 되어가는 느낌이랄까요?

디스크 I/O 간과하고 있던 부분인데요.(정말 생각지도 못했는데;) 차이가 말 그대로 어마어마 하더군요. 그간 램 용량 범위에서만 써서 몰랐었네요;

제가 하는 건 디스크로 쓰기가 잦은 느낌인데요. 레이드 카드(캐쉬빨?)로 엄청 가볍게 처리되고 있는 것 같습니다( 캐쉬에다 쓰고 I/O 끝 하는 듯..)

이로써 무리없는 거대한 램 용량을 얻은 것 같은 느낌이에요. 일반컴 포함 레이드 카드 없이 쓰는 시스템들은 다 SSD임에도 돌아가긴 가는데 프로세서 자원은 넉넉해도 스왑되면서 버벅이네요. I/O가 잦아지게 세팅하니 차이가 오바안하고 넘사벽인 것 같습니다. 어쨌든, 레이드카드란 것.. 참 좋은 거였군요+_+

비싼 건 왜 비싼지 아직 모르겠고 이건 왜 싼거지 싶고;; 아직은 좀 헷갈리네요. 찾다보니 지금 사용중인 레이드 카드도 꽤 괜찮은 건가 싶고요

말씀대로 상향 평준화된 건지 캐쉬도 있고 적절해 보이는 것들도 5만원 안팍이라 부담도 덜해 보이네요. 가능한 캐쉬 큰 거로 찾으려고요.

레이드 카드 새것 정품을 아직 못 구매 해보신 듯하네요...

보통 쓸만한 하드웨어 캐쉬 달린 8CH은 몇 십만원 (50-90)대 이고 24CH급은 200만원대가 넘어갑니다..

레이드 카드는 본래 비싼 것입니다..

내년엔 꼭 스토리지 서버 구축해봐야지 생각하고 있습니다. 박문형님 24bay스토리지 서버 보고 뽐뿌 받았습니다.(추천)^,~

지금은 그냥 이대로도 용도에 부족하지 않아(컨테이너들 개별로 다 모아놓으면 넘쳐서요) 쓰다가 내년에 시스템 바꿔보면서..

묙표대로 좋은 레이드 카드도 알아보고 써볼까 합니다. 조언 감사합니다.

세 시스템이 모두 동일한 SSD인지, RAID 카드에 물린 SSD들은 몇개를 RAID로 묶은 것인지 등등

가상머신들을 SSD에 설치한 것인지, 가상머신들을 하드디스크에 설치하고 SWAP 파일만 SSD에 잡은 것인지도 모르겠고요.

RAID 카드 cache가 1GB 정도일텐데 그게 그렇게 효과를 낸 것인지 의문입니다.

박문형님께서 SSD가 동시 멀티 IO에 약하다고 하셨는데, SSD가 강한 것이 바로 그쪽입니다.

7,200RPM하드디스크보다 15,000RPM 하드디스크가 강한 것이 그런 곳이고, 15,000RPM 하드디스크보다 강한 것이 SSD입니다.

하드디스크 수십개를 RAID0으로 연결해도 좋은 SSD 하나를 못당합니다. SSD 중에도 구린 SSD 10개를 RAID 0으로 묶어도 일의 종류에 따라 좋은 SSD 하나를 못당합니다.

E5-2689 V1과 E5-2670 V1은 여러대의 가상머신을 돌린다고 할 때 그리 큰 차이를 보이기는 어렵습니다. 비슷한 성능

E5-2689 쪽이 RAM이 많으니 당연히 유리

3대에서 사용하는 SSD가 같은 종류인지 RAID는 몇개를 묶은 것인지 궁금하네요. RAID 카드 cache가 위력을 발휘했다고 보기 어려운 상황이라서요.

RAID로 묶었다고 하더라도 cache 없는 RAID 카드나 소프트웨어 RAID나 cache 있는 RAID 카드나 RAID 0, 1, 10에서는 그리 큰 차이를 보이지 않습니다. RAID5, 6, 50, 60에서 매우 큰 차이를 보이는데요. SSD를 RAID 5, 6, 50, 60 등으로 묶은 것인가요? 하여간 궁금

반갑습니다.(__)

뭔가 다른 요인이 있을까요.. 좀 더 상세하게 적어보겠습니다. 추가로 더 의아한 부분들 있으면 알려주십시오.

각 시스템에 SSD 하나씩만 달려있고요.(꽤 단순합니다;)

2670시스템들만 레이드카드(rms25cb040)에 물려 가상드라이브로 잡아서 쓰고 있습니다.

OS와 도커 컨테이너들, 스왑 파일 모두 하나의 SSD에 있고요.

디스크에 존재하는 스왑파일의 크기는

2689 시스템은 총 36G의 스왑 파일 크기를..

2670은 총 68G의 크기입니다.

SSD 모델은,

2689는 v-nand ssd 850 120GB

2670은 둘 다 v-nand ssd 860 EVO 250GB

입니다.

(읽기는 제외하고)레이드 카드 프로세서와 캐쉬가 활용됨으로 인해 동시 쓰기에서 꽤 강력해지는 거 아닌가요.

(속도가 빠른)캐쉬에다가만 쓰고 I/O끝, 나머지 과정(실제 디스크에 기록)은 레이드카드 프로세서가 처리하게 되는 것으로 생각해서요.

현재 요구 용량이 순간적으로 캐쉬 크기를 넘을 정도는 아닌 것 같아 위 방식이라면 스왑(페이징)되는 과정이 램(실제론 캐쉬)으로의 쓰기 속도와 유사하게 된 것 아닌가 추측하고 있습니다. (SSD캐쉬 크기와 컨트롤러등 여타 변수들이 있긴 한데 현재론 레이드 카드 사용 유무가 차이의 주요한 이유가 아닌가 생각했습니다.)

디스크의 캐시가 레이드 카드의 캐시 대비 위력이 낮게 나타나는 건 동시에 접근할 때 (컨트롤러의) 처리 속도 차이가 아닐까 싶고요.

레이드 카드는 "A응 여기다 놔 끝, B끝, C끝,..FGH.. 걱정하지 말고 나는 전용 프로세서라고.. 놔 나중에 내가 디스크랑 꿍짝할게"(그렇게 전원이 나가게 되고..)

디스크는 "A 어 여기다.. 아 잠깐만 동시엔 오지마.. 아..B어디다 놔야 하지 D는 기다리라고.. C부터.. 아 버퍼가 차고 있어.. A 기록부터 하고 올게.. (이쯤에서 GG) 울먹.. 나도 하나씩 오면 꽤 효율이 좋은데.."

모르면서 그냥.. 적어본 겁니다;(--);;하하하. 이런 느낌으로 느끼고 있습니다. 고수님들 거슬려도 양해 부탁드립니다.(너무 용감하게 적었; 느낌 괜찮나요?

이런 느낌이라면 CPU랑 일부의 램이 조인해서 위의 레이드 카드(디스크 I/O버퍼)가 해내는 일을 할 수 있을 것 같은데요.. 뭔가 툴이 있지 않나요..)

말씀해주신 케이스들과 의견 감사합니다.

그러고보면 캐쉬 없는 레이드 카드들도 꽤 많아더군요? 왜 없죵..; 지원되는 레이드 방식이 조금씩 다르던데 가성비를 맞추려는 디자인(굳이 캐시가 필요없는) 일까요. 예를 들자면, 말씀해주신 캐시 유무 차이가 미미한 레이드 방식에서처럼 아마 그 레이드 방식이 디스크의 컨트롤러 및 캐쉬를 개별로 (활성화)분산 사용함(특징)으로 해서 차이(레이드 카드 캐쉬 유무)가 미미하게 나타난 것 아닐까 싶고요. 이런 특징의 방식만 지원할 경운 추가 캐시의 중요도가 조금 낮아 보이고요. 사실.. 아직 한번도 레이드로 묶어본 적이 없네요..(이거 좋은 거임?으로 느끼고 있는 수준입니다.) 해볼 때 꼭 참고하겠습니다. 도움이 되었습니다.(__) 가.. 가르침을..

덕분에 좀 더 생각해봤습니다.ㅎㅎ

그럼, QnA에서 뵙겠습니다.ㅠ 위키 좀 보다 올게요..

좋은 하루 되십시오.

한 시스템에는 120GB SSD를 달았고, 두 시스템에는 250GB SSD를 달았는데요. spec과는 달리 성능 차이가 크게 납니다.

Samsung 850과 860은 성능 차이가 별로 없습니다. 850과 860 차이가 아니라 120GB와 250GB 사이에 성능 차이가 큽니다.

SLC 구간 내에서는 용량에 관계없이 성능이 좋지만 그 구간을 벗어나면

sequential write 성능이

120GB - 150MB/sec

250GB - 300MB/sec

500GB - 500MB/sec

4K random write 성능도 마찬가지로 차이가 납니다.

용량에 따른 성능 차이는 enterprise SSD가 아닌 consumer SSD에서는 보통 나타나는 현상입니다.

swap 파일의 경우에는 sequential write보다 random write 성능이 크게 영향을 미칠 것입니다.

참고 : Anandtech의 850evo review

https://www.anandtech.com/show/8747/samsung-ssd-850-evo-review

* 850과 860 차이는 별로 없습니다. 용량에 따른 차이를 주목하세요.

더구나 120GB SSD와 250GB SSD에 같은 내용을 넣었다면 남아있는 용량이 120GB의 경우에는 적을 것입니다.(SWAP 파일 크기가 다르기는 하지만 그걸 고려해도 250GB SSD의 경우 남아있는 용량이 훨씬 클 것입니다. consumer SSD에서 남아있는 용량이 적을 경우에는 성능이 하락하는 것이 보통입니다.)

사용하시는 용도에 맞는 SSD라면

1. enterprise용 SSD

2. consumer용 SSD라면 인텔이나 삼성 등

3. consumer용 SSD라면 가능한 한 용량이 큰 것(최소 250GB 이상)

이런 순서로 고르시는 것이 좋습니다.

그리고 용량이 넉넉하다면 overprovisioning을 좀 더 잡아주시면 4K random write 성능이 크게 증가합니다.(SWAP 파일에 중요)

예를 들어 250GB라면 50GB를 더 overprovisioning하여 200GB 짜리로 만들어 쓰는 것입니다.

위에 링크한 Anandtech review의 그래프에서 overprovisioning에 따른 성능 차이를 보실 수 있습니다.

알려주신 설명들과 아난드텍 기사를 보고 나니 처음 보는 SSD에 적용된 기술들 포함 삼성매지션에서 얼핏 본 용어들이 이제야 이해가 됩니다.

(평소에 알아두면 좋을텐데;; 평소엔 알기가 싫더라고요;;)

아하 터보라이트 기술이 예비 영역인 오버-프로비져닝 영역의 1/3 영역을 SLC쓰기처럼 구현한 버퍼로써 사용해 쓰기 속도를 향상시키는 거군요.

후에 다른 영역으로 옮겨지고요. 와우.. 터보라이트 구간과 아닌 구간의 그래프는 얼핏 본 적이 있습니다. 뭐지..하고 그냥 넘겼는데요. 이걸 의미하는 거였군요.

SSD도 그냥 적당한 거 쓰면 적당히 최선이겠지 싶어서 별로 관심이 없었네요;;ㅠㅠ(다나와에서 누가 SSD는 고민하지 말고 닥 삼성이면 된다고 그래서요..)

흠.. 게다가 순차, 램덤 상관없이 이 기술이 활용되고 있군요. 이 영역을 다 쓰고나면 TLC 속도로 돌아오고요.

제가 쓰는 850과 860이 이 부분에서 유의미할 정도의 차이가 있네요.

현재 제 시스템에서 850은 터보라이트 영역이 3G로 한정된 상태지만 860은 신기술 Intelligent TurboWrite로 필요시 9G가 추가되어 총 12G를 터보라이터 영역으록 알아서 활용이 되는 군요.

그리고 PC의 램을 캐쉬&쓰기버퍼로 쓰는 기술이(위에 제가 이런 거 없나요라고 적었는데) 그게 레피드 모드였군요.

매지션에서 본 것 같습니다. 뭔지 모르지만 좋은 건가 싶어서 적용해서 벤치 돌리니 수치가 너무 높게 이상하게 나왔던 기억이 있네요.

근본적으로 용량별로 성능차가 발생하는 느낌은 알고는 있었지만 왠지는 잘 몰랐습니다.

지금 찾아보니 채널수 차이로 병렬로 처리해 입출력 성능이 증가하는 거군요.

가격차가 좀 있을 때 850 120G를 구했는데요. 후에 몇 달 안되서 860 250G과 가격차가 미미해졌더군요;(눈물)

간장게장님 꿀팁 대박 감사합니다. 진짜 덕분에 SSD랑 친해진 것 같습니다. 사실 SSD니까.. 좋다는데.. 그냥 알아서 잘 하겠지 싶었는데요.

제가 잘 해야 되는 거군요.. 그리고 덕분에 최적화를 시도해볼 방향이 잡힌 것 같습니다.

알려주신대로 오버프로비져닝 공간 확보&래피드 모드 활성화 방향으로 한번 시도해봐야 겠습니다.(__)

마지막으로 제가 하나 정리해야 겠는데요.

위 현상의 차이가 레이드 카드 차이냐 SSD 차이냐로 초점이 양분된 상태인데요.(나 때문에..ㅠ) 결론은..

여러분들 각자의 몫으로 남기겠습니다... (열린 결말)

(하하하..)

저는 둘 다라고 생각합니다 '_'

그런데요 SWAP에 들어가는 순간 Memory Access 속도가 20배 드려집니다.

SWAP DISK를 RamDisk로 만들고 사용해도 20배 드려집니다.

SWAP DISK가 SSD, RAID 아래 SSD 건 다 필요없습니다.

SWAP은 무조건 피해야 합니다.

특히 ram의 일부를 ram disk로 만들어 거기에 swap 파일을 넣는 것은 배 빌려주고 뱃속 빌어먹는 짓.

은행에서 대출 받은 돈을 다시 은행에 정기예금 들어 놓고 이자 받은 것으로 대출 이자 갚고 남는 것으로 빵 사 먹으려는 것이나 마찬가지. ㅎ

그런데 ram 값보다 SSD 가격이 싸니 swap 파일을 고려해 볼 수도 있습니다.

ram이 80gb 장착되어 있는데 평소에 ram 요구량이 100gb 쯤 되어 항상 swap 파일 입출력이 있는 경우라면 당연히 ram을 128gb 정도로 늘리는 것이 맞습니다.

그러나 80gb 장착되어 있는데 보통 때는 60gb 미만으로 사용하고 어쩌다 가끔씩만 ram 요구량이 100gb 정도로 늘어나는 경우라면 4k 성능이 좋은 ssd에 swap 파일을 넣어 사용하는 것도 고려할 수 있을 겁니다.

더 큰 문제는 SWAP이라는 방식이 너무나 불안하다는데 있습니다.

HW 적인 효율만으로 보면 간혹 필요한 메모리 용량을 위해서 그만한 메모리를 장착하는것 보다는 좀더 저렴한 SSD 등으로 SWAP을 만들어 사용하는게 좋아보일 수 있습니다.

하지만 (기업이라면) 전체적인 기회비용이 너무 큽니다.

SWAP에 들어가는 순간 전체 시스템의 성능이 몇배 나빠지고 결과적으로 해당 VM에서 돌아가던 작업 response 시간이 전혀 예측이 불가능해 집니다.

최악의 경우이지만 SWAP 사용중에 HW에 문제가 발생해서 멈추기라도 하면 VM 자체를 손실하는 경우도 다반사 입니다.

그렇기 때문에 VM Hypervisor에서 SWAP이 발생하는건 무조건 막아야 합니다.

살짝은 꽤 괜찮았는데요. 컨테이너들을 늘려가며 점차 swap 의존도를 올려가니 문제가 확실히 있네요.

2670 시스템중 48기가짜리는 컨테이너가 사실 58개였는데요. (컨테이너당 램 요구는 점차 늘어나 1기가 조금 넘게까지 사용됩니다.)

여기서 4개만 더 추가했을 뿐인데 동일 시스템에 램만 8기가 높은 시스템(62개가 무난함)은 돌아가는 게 안되네요.

스왑 파일로 IO발생할 때 idle 수치(대기타는 프로세스들 발생)도 올라가며(*저는 이게 잉여 자원인 줄 알았네요;;) 프리징이 걸리더군요.

제 기대완 다르게 쾌적하지가 않아요;

충고해주신대로 기업이나 상용 서비스등에선 절대적으로 SWAP은 피하는 게 진리인 걸 느끼게 되었고요.

추가로 간장게장님 말씀대로 스왑 파일로의 스와핑 요구도가 낮을 땐 적절한 구성과 세팅하엔 괜찮구나도 동시에 경험한 것 같습니다.

근본적으로 swap관련해 epowergate님이 관점을 환기시켜 주셨네요. 감사합니다.

램이 적어도 스왑만으로도 용도에 따라 충분히 커버가 될지도 모르겠다는 바람은 일단은 저의 꿈으로 남겨두어야 겠습니다..;_;

(일단은이라 한 건.. 미련은 조금 남아 선데요; 천천히 스왑되면 될 것도 같은데요..

갑자기 '뽞'하면서 IO수치가 0%에서 동시에 올라가 확 튀어 버리더군요. 뭔가 그냥 조금씩 조금씩 최적으로 쓰면 될 것도 같은데 말입니다..

레이드 카드의 이해도와 SSD의 세팅등 여러 가지를 계속 천천히 하고 컨테이너 램 사용 계획등 여러 가지로 튜닝해보면 얻는 게 있을 것 같습니다)

감사합니다.

그럼 모두 좋은 하루 되십시오.(__)