안녕하세요

r740xd 에 24bay full nvme를 시도해보고 있는데요.

생각보다 많이 어렵네요. 그냥 애드온 확장 카드만 좀 끼우면 될줄 알았더니

12bay sas + 12bay nvme 까지는 성공하였으나..

full nvme는 riser 카드도 바꿔야하는데 full nvme 24bay 를 저처럼 드래곤볼로 하려는 사람들이 잘 없는것인지

해당 부품이 애프터마켓에 잘 없고.. 새것만 팔고있네요 ㅜ.ㅜ

r740xd 에 h750 레이드카드가 지원되느네 sff 24bay 까진 호환 케이블이 있지만

(GHNCR / G5KWM)

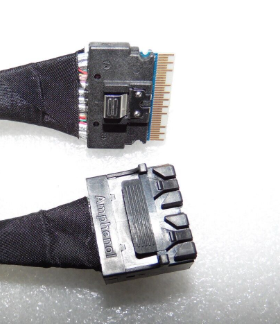

윗쪽이 24bay backplane 에 꽂혀야하는 커넥터이고

아래쪽이 mini sas dual 로 h730 이나 h740에 꽂는 타입인데

h750은

이런 커넥터 이거든요

즉 h750커넥터와

이 커넥터가 있어야하는데

이 부품은 아무리 찾아도 안보이네요..

dell이 밴더사중에 그나마 부품 정보가 잘 나와있다고 생각하는데도 참 부품 찾기가 어렵습니다 ㅜㅜ..

혹시 케이블이 존재하는지.. 부품번호 아시는분 있으실까요?

백플레인의 SAS케이블 커넥터는 아래와 같이 생겼습니다.

자잘한 부품 구하기가 참 어렵네요 ㅜ.ㅜ

이건 안되나요?

백플레인쪽은 사진이 좀 불분명해서 확실히 모르겠네요..

https://www.ebay.com/itm/405142264702

이 케이블이 맞는지 모르겠습니다..

SFF-8654(8x) 커넥터는 현재 팔리는(최신) NVME 레이드 카드에 거의 다 사용되는 추세입니다..

(아답텍, 아레카, LSI)

이 커넥터를 사용한 케이블은 한가닥에 PCIe 8x 의 신호를 보낼수 있습니다..

https://www.stc-cable.com/ko/internal-slimline-sas-sff-8654-to-oculink-cable-sff-8611-cable-product/

http://www.raidmall.com/shop/shopbrand.html?xcode=003&type=M&mcode=015&scode=009

반대쪽은 이런 식의 커넥터를 사용한 제품도 있습니다..

sff-8654 8i (slim sas) 와 h750 포트는 뭔지 모르겠지만.. 1포트와 1포트 입니다

dell은 케이블 길이 조차 맞아야해서.. 케이블 포트 구멍만 맞는다고 또 되는게 아니더라구요

(데이터는 흐르는데 디스크 순서가 바뀌어 있던지 억세스, Fail LED가 재대로 동작하지 않던지 하는 문제가 발생할 수도 있습니다..)

슈퍼마이크로도 웬만해서는 리테일 케이블이 먹히나 그 쪽도 자기네 전용 파츠를 사용하라고 강하게 권장합니다..

요즘 최신 시스템은 보드와 보드사이에도 PCIe 케이블로 연결하는데 국내에는 제조할 수 있는 공장이 없으며 제조가 가능하다고 해도 국내 수요가

거의 없다 싶이하기에 제조사 입장에서는 만들면 손해만 날 수 있습니다..

요즘 컴퓨터 뉴스들을 보며 자꾸 생각나는 것은 규모의 경제입니다..

우리나라는 인구가 적고 그에 따른 산업 경제 크기가 작기 때문에 하지 못하는 것들이 굉장히 많습니다..

Figure 2 의 6번 과 h750 연결입니다.

dell 은 설계를 별별 방법으로 어떻게든 파츠를 새로 사게 만들더라구요.

h750도 r740xd에 호환된다면 백플레인 타입에 따라 보통 호환 파츠를 다 내놓을텐데..

h750도 lff sff 까지는 있는데

full nvme 백플레인 부터는 해외에도 h740p 까지만 있고 h750은 정보가 없네요 ㅜ.ㅜ

제가 추측해 볼 때

24bay Backplane 은 NVME /SAS /SATA 겸용이며 NVME 연결시 NVME 커넥터에만 데이터 케이블을 연결해서 NVME 레이드 카드로 연결되고

SAS/SATA 연결시 SAS 커넥터에만 데이터 케이블을 연결해서 SAS 레이드카드로 연결되는 구조이며 (전원이나 LED시그널 등은 공통인 듯)

BackPleane 에 NVME용 PCIe Expander 와 SAS용 SAS Expander 가 각각 따로 장착된 것으로 보여집니다..

문제는 현재 조립 단서는 저 메뉴얼 하나 뿐이라는 것입니다.. 안에 내용도 디테일하지 않고요..

https://www.reddit.com/r/homelab/comments/15rls28/r740xd_with_24_nvme_drives_working_dell_parts_list/?rdt=51701

여기서 부품번호는 모두 찾았습니다.

그런데 저 SAS케이블은 raid 카드에 따라 부품이 달라지니 비워져있네요.

왠만한 문서는 다 읽어본것 같은데

아무래도 dell 에 문의를 드려봐야할것 것 같습니다 ㅜㅜ

시도 하지 마세요.

지원하지 않아요..

Full 24 NVMe에 필요한 PCIe Lane 수

24 x 4배속 = 96 Lanes 가 필요합니다.

CPU가 지원하지 않아요..

(정확히는 스케일러블CPU 1, 2 세대의 PCIe 레인이 모자라요. )

(예 Xeon Gold 6240 Pcie Lane : 48 Lanes)

중간에 PCIe Switch 가 있어야 합니다.

PCIE 3.0 X16배속을 공유하도록 하는 스위치가 있는데.. 백플레인도 있을 겁니다.

그러나 Full NVMe 속도가 나오지 않겠죠.

R750도 지원하지 않고..

R760에서는 비로소 지원하게 됩니다...

CPU중에 PCIe 80 lanes 를 지원하는 CPU가 나왔습니다.

거기서 부터 지원합니다.

80 x 2 = 160 중에 96 Lanes 를 사용합니다..

(예 : Xeon Gold 6444Y Pcie Lane : 80 Lanes)

(필요한 100G NIC 16 Lanes 필요)

그래서 160 - 96 -16 == 48 Lanes 만 남아요.. 이걸로 Dual 시스템 꾸려야 하죠.

물리적인 한계에요.

U.2 는 SAS/SATA 와 소켓을 공유하지 않습니다. 배선이 달라요.

그러므로 백플레인 자체가 NAMe용이 따로 있어요.

U.3에 가서 통합되었습니다.

pci-e 슬롯에 장착되는 2개의 pci 스위치( 부품번호 w0dnk ) 가 cpu당 36개 레인안에서 작동시키는것 같습니다.

SAS 24개 채우나 nvme 24개 채우나 IO 를 다 활용하지는 못하지만 레이드10 으로 했을떄 그래도 지연율이 SAS대비 10배나 빠르다는 관념을 가지고 있어서 DB 서버가 목적이다보니 고IOPS 를 현 보유한 기종내에서 처리한다가 주 목적이어서 nvme 를 시도해보고 있습니다.

https://forums.truenas.com/t/has-anyone-tried-dell-r730xd-or-r740xd-with-nvme/856?page=2

amd 기종인 r7425와 7525는 레인이 지원되고 cpu와 직결이라 알고 있습니다지만

r740xd 로 시도하는 이유는 우선 보유기종내에서 .. 회사의 자원내에서 최대한 해보려고

또 24bay nvme 에 대한 경험이 없어서 레거시 기종에 대해 경험치 확보 목적도 있습니다.

cpu 자체가 48레인 으로.. 기본적으로 소모해야 하는 pcie Lane 이 있습니다.

Mainboard Layout 를 확인하세요.

H750도 U.2 하나당 2 Lane 밖에는 배정을 못할 거에요.

결국

위의 드로잉을 보니.

24 NVMe Backplane 필요하고요.

PCIe-Nvme 카드 2장

케이블 4개

U.2 8개 짜리를 ==> 24 개 로 분기 하는 분기스위치. (24 Nvme Backplane 뒤에 추가로 붙는 에드온)

IOPS와 지연율만 생각한다면 SAS 24개 보다 좋은 선택일까요?

심지어 NVME가 SAS보다 DISK가 더 저렴하더라구요.

아.. 애드온 하나당이 아니라 둘 합쳐 32 였군요..

firesyde424

a.dresner

May 2024

“Does the Dell PE PCI-E 12x NVMe Drive Expander Card pass the disks through, it seems to be an HBA. Thanks!”

Yes, it does. The PCIE “switches” or “expander cards” that Dell ships with NVME enabled servers of that generation pass through on TrueNAS Core without any issues.

1st and 2nd gen Intel Xeon Scalable CPUs don’t have enough PCIE lanes to run more than a few NVME drives each so the expander cards are a requirement. You only get 32 lanes from those cards. In practice, most workloads won’t use that kind of bandwidth regularly so it should be just fine.

Link to current TrueNAS server configurations can be found here.

위 링크 저도 계속 매달리고 있다보니 봤던 문건이긴 합니다.

HBA 모드처럼 디스크당 독립적으로 작동하고

스케일러블 1,2세대에서 lane수가 모자라 제한된 lane으로 운영되지만

일반적인 워크로드에서 해당 대역폭을 다 사용할일이 없어 충분할거다 라는 의미로 해석했습니다.

그 아래

You’re asking some great questions.

The BOSS S-1 is for 14th generation servers that don’t have dedicated BOSS slots on the chassis. The S-1 is just a normal PCIe card that has 2 M.2 SATA ports on it.

The BOSS S-2 is for 15th generation servers. The form factor is proprietary and makes accessing the SATA SSD’s easier because they attach to little sleds in the back of the server.

The BOSS N-1 is for Dell’s newest 16th generation servers. They are M.2 NVMe rather than the previous S-1 and S-2 being M.2 SATA.

Regarding the questions about the r740xd vs the r7425, the IO topology diagrams spells things out nicely.

For the R740XD 24x NVMe backplane, it requires 2 extender cards. 12 drives cabled to each card via 2x8 cables. I’m not sure why the diagram says it’s an x16 cable because its 100% 2 separate cables to each of the extender cards. Either way, you’re taking 12 drives at 4 lanes each (48 lanes) and using a PCIe switch on the back of the backplane to switch that down to 16 lanes. Which means you’re getting ~0.33 lanes (EDIT: 1.33 lanes) per drive.

For the r7425 you’re still using PCIe switches, except now you don’t need PCIe extender cards, you’re just mapping those lanes directly to the CPU. However you’re still switching, but according to Dell’s diagram its a 31:16 ratio (or ~0.5 lanes per drive). Something I don’t understand about the 7425 though is why they depict 12 drives only being 31 lanes when we all know it’s 48 lanes. Regardless, I would echo @firesyde424 's advice and go with the AMD based system.

에서 0.33 으로 표현했지만 nvme pci-e 카드 1개당 16레인으로 2개에 총 32레인이므로 1디스크당 32나누기 24 하여 1.33 레인으로 ..

레이드10 시 12개 대역폭 묶어 논리적으로 최대 15GB/s 정도 기대해보고 있습니다.

목적이 DB서버이긴 합니다만 랜덤 IOPS read 가 어느정도 나오는지 보기 위함입니다. 이게 잘 나와야.. 4세대든 5세대든 AMD로 가든.. 생각해볼 수 있어서요.